L’annulation de ce décret laisse entrevoir un développement de l’intelligence artificielle de plus en plus dérégulée aux États-Unis et marque encore un peu plus une rupture avec l’Union européenne.

C’est une ligne comme une autre dans la longue liste des décrets recensés dans le communiqué de la maison blanche intitulés « premières annulations de décrets et d’actions préjudiciables »,publié le lundi 29 janvier, jour de l’investiture du 37e président des États-Unis.

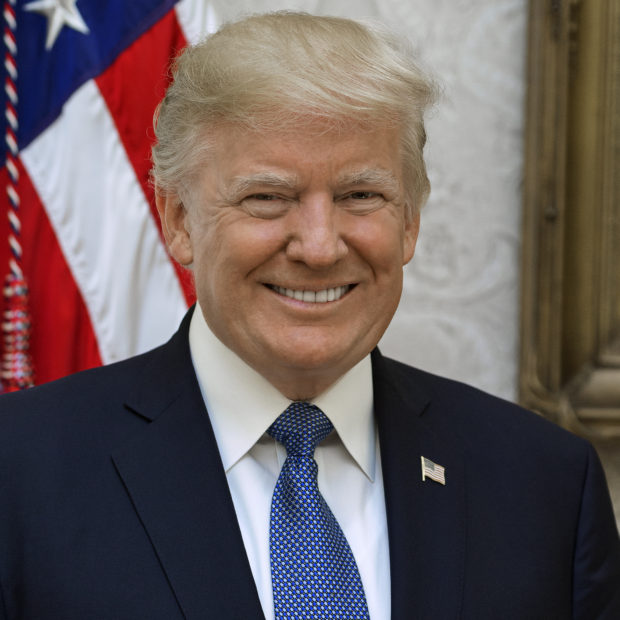

Donald Trump a abrogé le décret exécutif 14118 du 30 octobre 2023 sur le développement et l’implantation de normes/exigences de confiance de l’intelligence artificielle promulgué par son prédécesseur, Joe Biden. Ce texte, perçu par beaucoup comme un frein pour l’innovation, imposait aux entreprises de transmettre au gouvernement fédéral des données et résultats de tests relatifs à leurs modèles d’IA lorsqu’ils présentaient « un risque sérieux en termes de sécurité nationale, de sécurité économique nationale, ou de sécurité de la vie privée et des libertés individuelles ». Le texte imposait également au NIST (National Institute of Standards and Technology) de définir des normes ainsi que d’autres agences fédérales d’évaluer les risques biologiques, radiologiques, nucléaires, de cybersécurité ou d’infrastructure critique que l’IA pourrait poser.

L’IA sans entrave

Cette nouvelle annulation marque un peu plus la rupture entre le modèle de développement adopté par les États-Unis et celui de l’Union européenne, porté par l’IA Act et dont les premières exigences s’appliqueront dès le 2 février. Ce règlement doit établir des règles en matière de sécurité des usages, tout en limitant l’impact sur l’innovation dans le domaine de l’IA, un secteur ou l’UE accuse un retard significatif par rapport aux Etats-Unis.

Ce n’est pas la première fois que les autorités rétropédalent sur un texte autour de la sécurité de l’IA. A L’échelle des Etats par exemple, en septembre 2024, Gavin Newsom, le gouverneur démocrate de l’État de Californie, a mis son veto sur un projet de loi baptisé SB 1047. Le texte devait imposer aux développeurs des tests de sécurité, d’audits, ou encore de mécanismes de désactivation des systèmes d’IA en cas de risques imminents. Gavin Newsom avait motivé son veto par le besoin impérieux « de protéger le leadership des États-Unis ».